社区微信群开通啦,扫一扫抢先加入社区官方微信群

社区微信群

社区微信群开通啦,扫一扫抢先加入社区官方微信群

社区微信群

负载均衡技术对于一个网站尤其是大型网站的web服务器集群来说是至关重要的!做好负载均衡架构,可以实现故障转移和高可用环境,避免单点故障,保证网站健康持续运行。

由于业务扩展,网站的访问量不断加大,负载越来越高。现需要在web前端放置nginx负载均衡,同时结合keepalived对前端nginx实现HA高可用。

(1)nginx进程 基于Master+Slave(worker)多进程模型,自身具有非常稳定的子进程管理功能。

在Master进程分配模式下,Master进程永远不进行业务处理,只是进行任务分发,从而达到Master进程的存活高可靠性,Slave(worker)进程所有的业务信号都 由主进程发出,Slave(worker)进程所有的超时任务都会被Master中止,属于非阻塞式任务模型。

(2)Keepalived 是Linux下面实现VRRP备份路由的高可靠性运行件。基于Keepalived设计的服务模式能够真正做到主服务器和备份服务器故障时IP瞬间无缝交接。二者结合,可以构架出比较稳定的软件LB方案。

keepalived可以认为是VRRP协议在Linux上的实现,主要有三个模块,分别是core、check和vrrp。

VRRP协议:

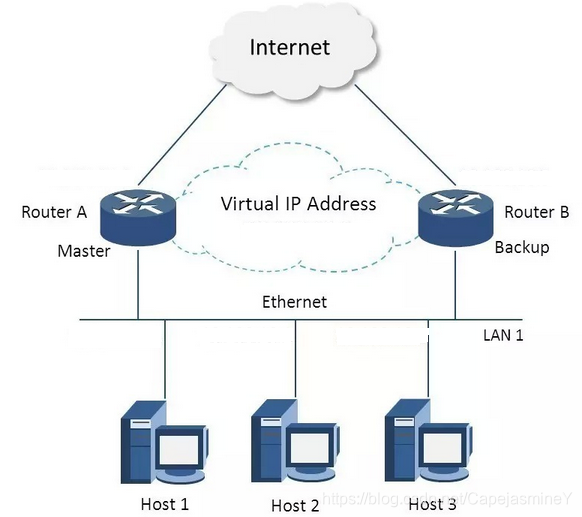

VRRP全称 Virtual Router Redundancy Protocol,即 虚拟路由冗余协议。可以认为它是实现路由器高可用的容错协议,即将N台提供相同功能的路由器组成一个路由器组(RouterGroup),这个组里面有一个master和多个backup,但在外界看来就像一台一样,构成虚拟路由器,拥有一个虚拟IP(vip,也就是路由器所在局域网内其他机器的默认路由),占有这个IP的master实际负责ARP相应和转发IP数据包,组中的其它路由器作为备份的角色处于待命状态。master会发组播消息,当backup在超时时间内收不到vrrp包时就认为master宕掉了,这时就需要根据VRRP的优先级来选举一个backup当master,保证路由器的高可用。

在VRRP协议实现里,虚拟路由器使用 00-00-5E-00-01-XX 作为虚拟MAC地址,XX就是唯一的 VRID (VirtualRouter IDentifier),这个地址同一时间只有一个物理路由器占用。在虚拟路由器里面的物理路由器组里面通过多播IP地址224.0.0.18 来定时发送通告消息。每个Router都有一个 1-255 之间的优先级别,级别最高的(highest priority)将成为主控(master)路由器。通过降低master的优先权可以让处于backup状态的路由器抢占(pro-empt)主路由器的状态,两个backup优先级相同的IP地址较大者为master,接管虚拟IP。

nginx 双机高可用一般是通过虚拟IP(飘移IP)方法来实现的,基于Linux/Unix的IP别名技术。

Keepalived所使用的负载均调度机制由集成到内核中的IPVS模块提供, IPVS是LVS项目的核心功能模块,其设计的主要目的之一就是解决单IP多服务器的工作环境,IPVS模块使得基于TCP/IP传输层( 第4 层)的数据交换成为可能。在实际使用中, IPVS会在内核中创建一个名为IPVS Table的表,该表记录了后端服务器的地址及服务运行状态,通过IPVS Table, Keepalived便可跟踪并将请求路由到后端物理服务器中, 即LVS Router利用此表将来自Keepalived 虚拟服务器地址的请求转发到后端服务器池中,同时将后端服务器的处理结果转发给客户端。

1)Nginx+keepalived 双机主从模式:即前端使用两台服务器,一台主服务器和一台热备服务器,正常情况下,主服务器绑定一个公网虚拟IP,提供负载均衡服务,热备服务器处于空闲状态;当主服务器发生故障时,热备服务器接管主服务器的公网虚拟IP,提供负载均衡服务;但是热备服务器在主机器不出现故障的时候,永远处于浪费状态,对于服务器不多的网站,该方案不经济实惠。

2)Nginx+keepalived 双机主主模式:即前端使用两台负载均衡服务器,互为主备,且都处于活动状态,同时各自绑定一个公网虚拟IP,提供负载均衡服务;当其中一台发生故障时,另一台接管发生故障服务器的公网虚拟IP(这时由非故障机器一台负担所有的请求)。这种方案,经济实惠,非常适合于当前架构环境。

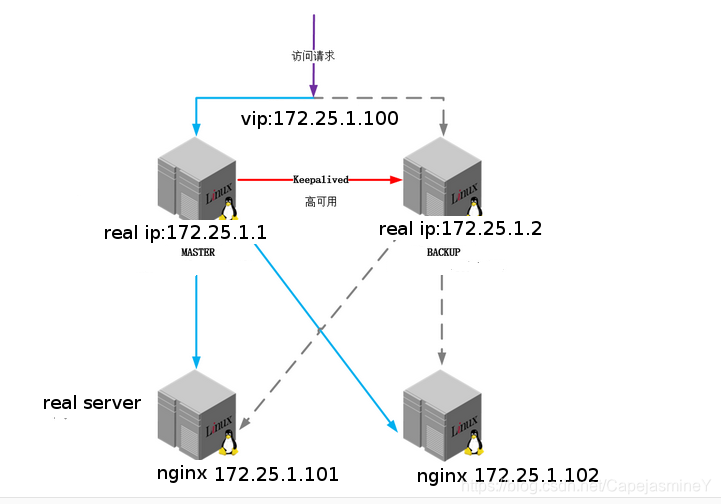

搭建Keepalived高可用故障切换转移集群,用server1作为主Keepalived节点和server2作为备Keepalived节点。keepalived负载均衡调度后端nginx主机server3和server4,后端两台nginx服务器给用户提供相同服务。

| 主机名 | ip | 服务 | 版本 |

|---|---|---|---|

| server1 | 172.25.1.101 | nginx | rhel6.5 |

| server2 | 172.25.1.102 | nginx | rhel6.5 |

| server3 | 172.25.1.1 | keepalived主 | rhel7.3 |

| server4 | 172.25.1.2 | keepalived备 | rhel7.3 |

| 真机 | 172.25.1.250 | 客户端,测试用 | rhel7.3 |

在keepalived主调度器(server3)上:

安装keepalive服务(master和backup两台服务器上的安装操作完全一样)

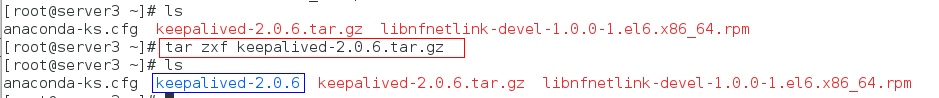

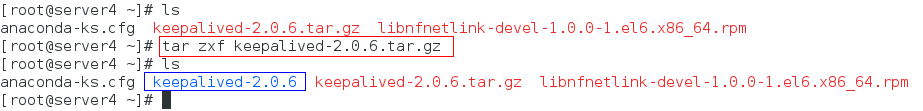

步骤一:网上下载keepalived服务压缩包,并解压

tar zxf keepalived-2.0.6.tar.gz

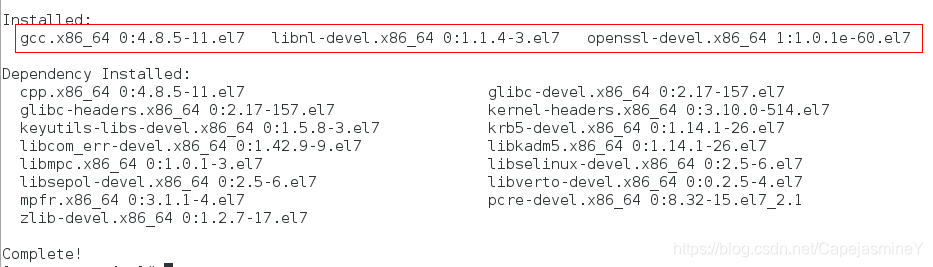

步骤二:下载源码编译所需软件及解决依赖项

一般是编译过程中报错提醒需要安装某些依赖项,然后安装,直到编译不报错。

yum install openssl-devel gcc libnl-devel -y

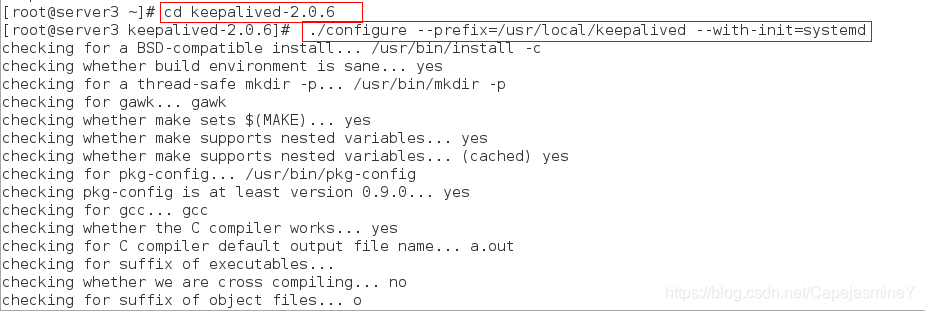

步骤三:编译

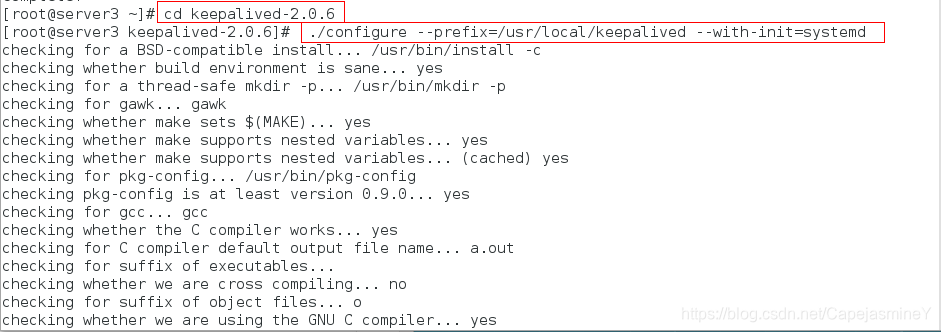

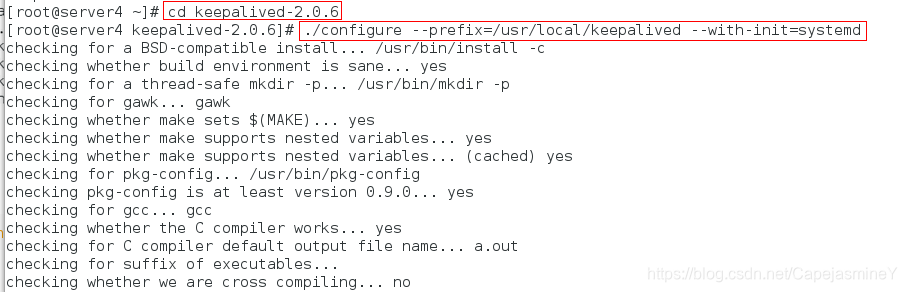

./configure --prefix=/usr/local/keepalived --with-init=systemd

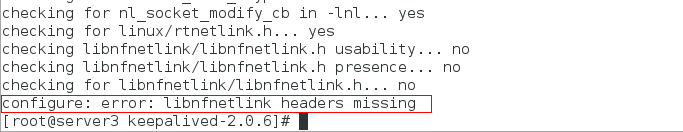

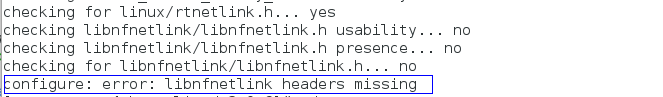

编译报错,提示缺少libnfnetlink-devel,解决办法:

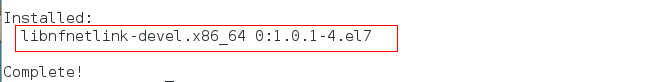

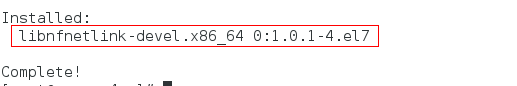

yum install libnfnetlink-devel-1.0.1-4.el7.x86_64.rpm -y

重新编译:

步骤四:源码安装

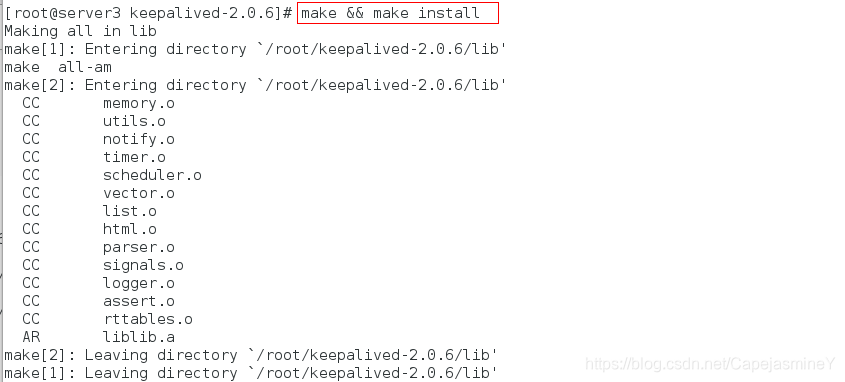

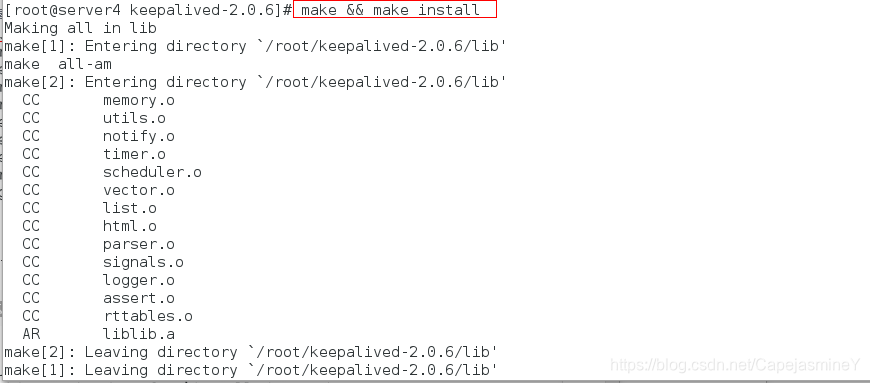

make && make install

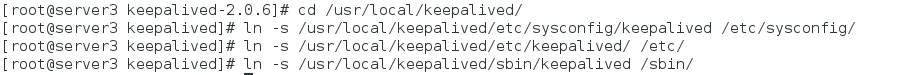

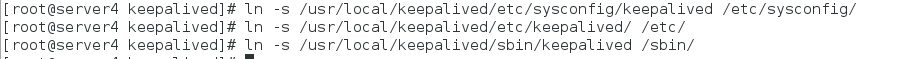

步骤五:设置软链接,方便使用

cd /usr/local/keepalived/

ln -s /usr/local/keepalived/etc/sysconfig/keepalived /etc/sysconfig/

ln -s /usr/local/keepalived/etc/keepalived/ /etc/

ln -s /usr/local/keepalived/sbin/keepalived /sbin/

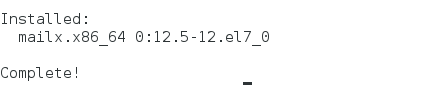

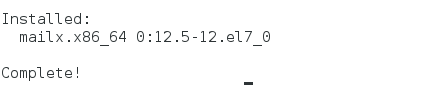

步骤六:下载邮件服务,可以看到会有邮件告知哪台的down了

yum install mailx -y

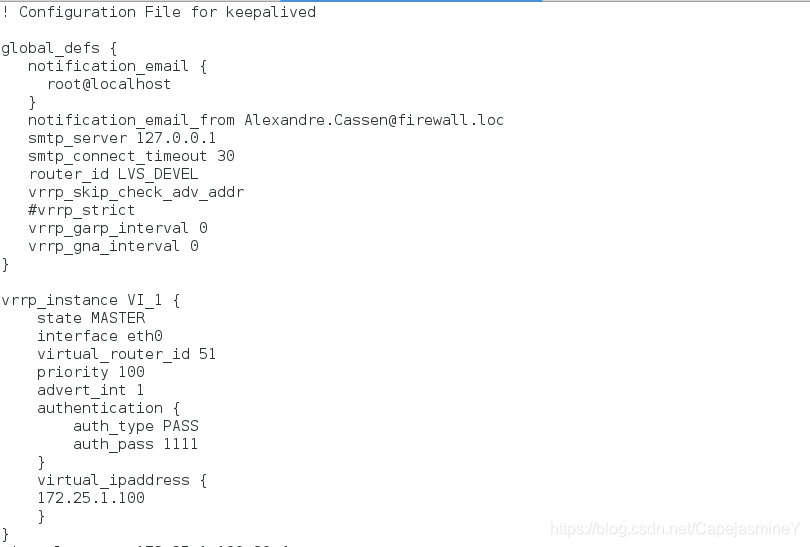

步骤七:修改keepalived配置文件

vim /usr/local/keepalived/etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

notification_email {

root@localhost #节点宕机给谁发送邮件

}

notification_email_from keepalived@localhost ##发送人名称

smtp_server 127.0.0.1 #发送服务器(本机)

smtp_connect_timeout 30

router_id LVS_DEVEL

vrrp_skip_check_adv_addr

#vrrp_strict #注释掉,不然会有问题

vrrp_garp_interval 0

vrrp_gna_interval 0

}

vrrp_instance VI_1 {

state BACKUP

interface eth0

virtual_router_id 51

priority 50

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

172.25.1.100 #VIP

}

}

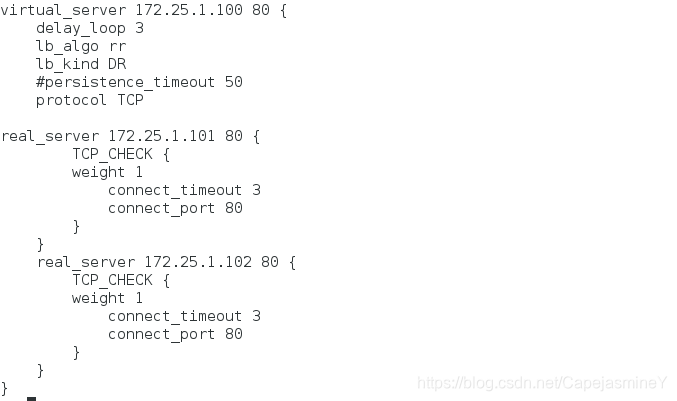

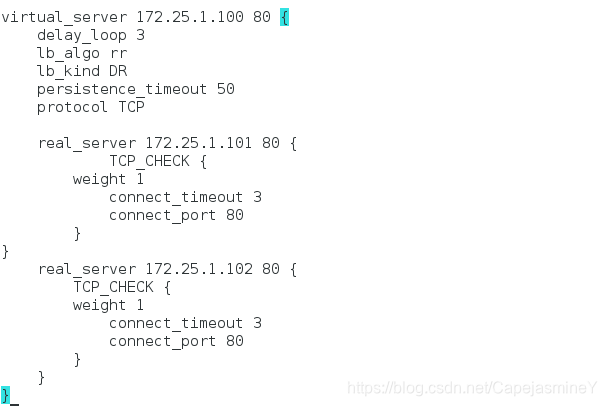

virtual_server 172.25.1.100 80 {

delay_loop 3 #当rs报错时,尝试多少次之后才邮件告知

lb_algo rr

lb_kind DR #DR模式

#persistence_timeout 50

protocol TCP

real_server 172.25.1.101 80 {

TCP_CHECK {

weight 1

connect_timeout 3

connect_port 80

}

}

real_server 172.25.1.102 80 {

TCP_CHECK {

weight 1

connect_timeout 3

connect_port 80

}

}

}

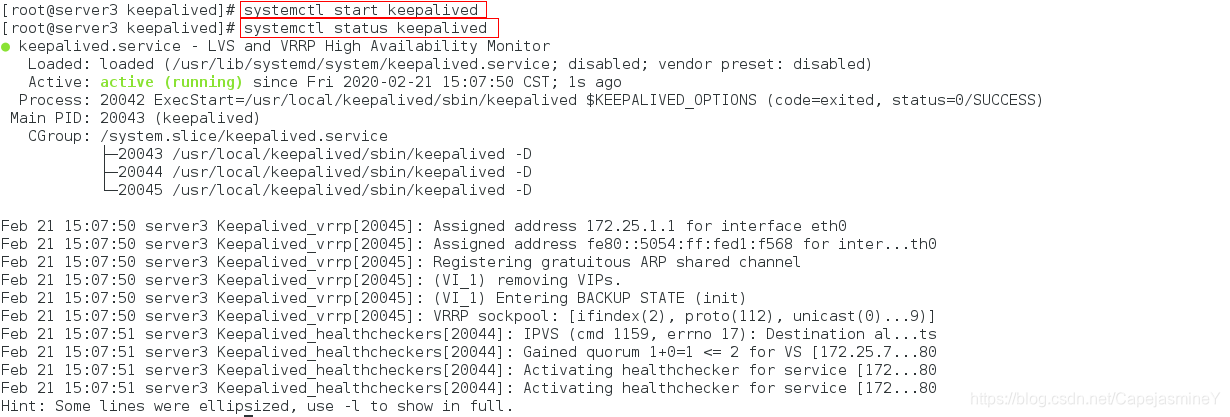

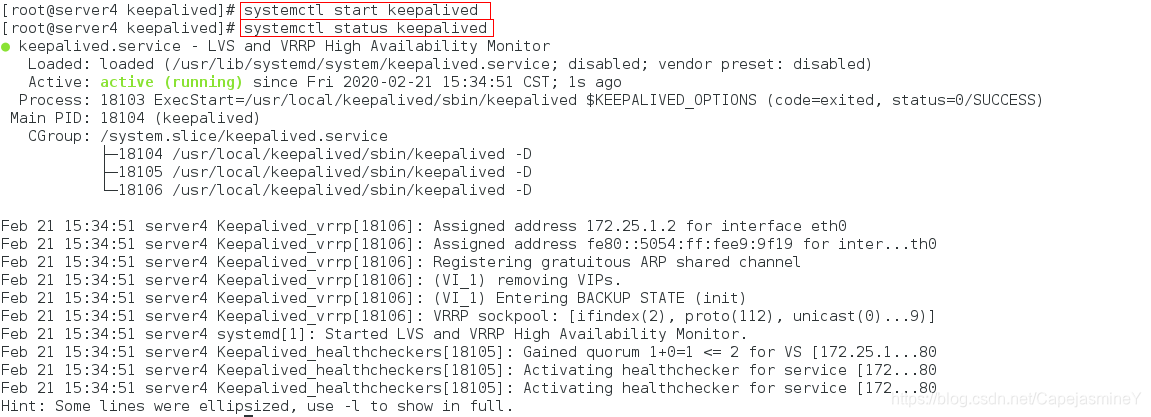

步骤八:开启keepalived服务

systemctl start keepalived

systemctl status keepalived

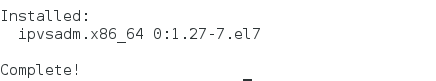

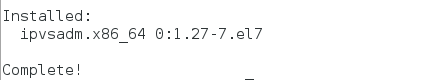

步骤九:安装ipvsadm服务

yum install ipvsadm.x86_64 -y

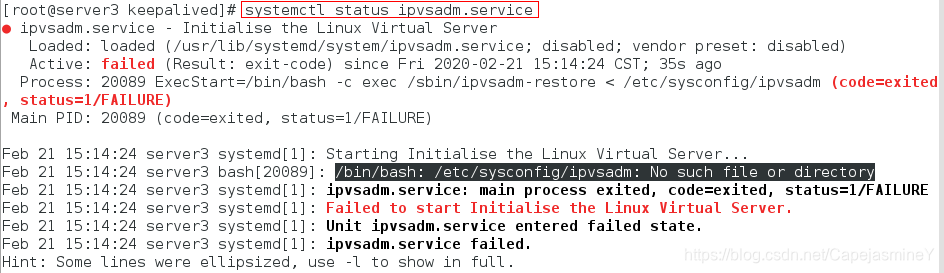

步骤十:开启ipvsadm服务

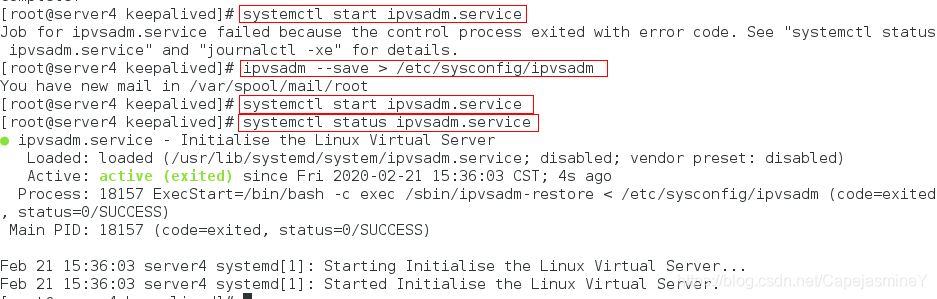

systemctl start ipvsadm.service

报错如下:

Job for ipvsadm.service failed because the control process exited with error code. See “systemctl status ipvsadm.service” and “journalctl -xe” for details.

查看ipvsadm状态:

systemctl status ipvsadm.service

解决:

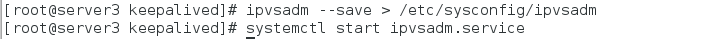

解决:

ipvsadm --save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

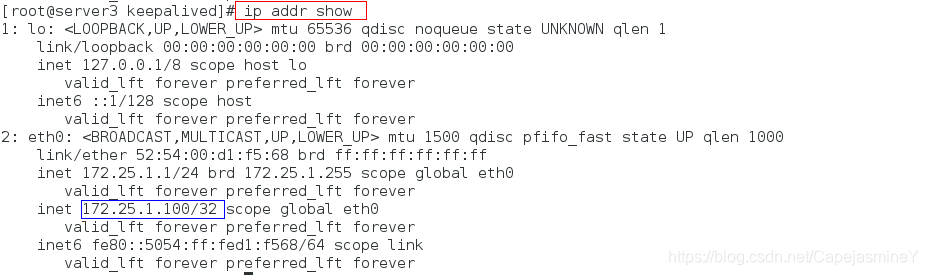

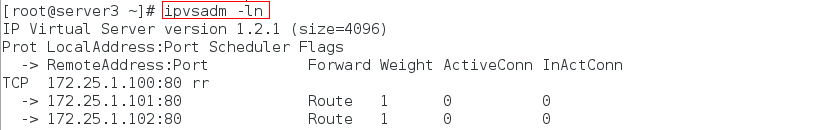

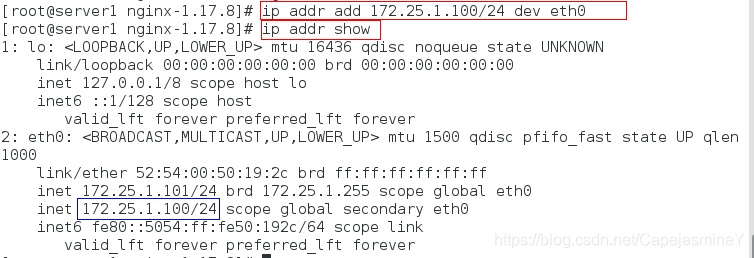

步骤十一:可以查看到eth0网卡上自动生成vip,及自动生成ipvsadm策略

ip addr show

ipvsadm -ln

在keepalived主调度器(server3)上:

在keepalived主调度器(server3)上:

安装keepalive服务(master和backup两台服务器上的安装操作完全一样)

步骤一:网上下载keepalived服务压缩包,并解压

tar zxf keepalived-2.0.6.tar.gz

步骤二:下载源码编译所需软件及解决依赖项

一般是编译过程中报错提醒需要安装某些依赖项,然后安装,直到编译不报错。

yum install openssl-devel gcc libnl-devel -y

步骤三:编译

./configure --prefix=/usr/local/keepalived --with-init=systemd

编译报错,提示缺少libnfnetlink-devel,解决办法:

yum install libnfnetlink-devel-1.0.1-4.el7.x86_64.rpm -y

再次编译:

步骤四:源码安装

make && make install

步骤五:设置软链接,方便使用

cd /usr/local/keepalived/

ln -s /usr/local/keepalived/etc/sysconfig/keepalived /etc/sysconfig/

ln -s /usr/local/keepalived/etc/keepalived/ /etc/

ln -s /usr/local/keepalived/sbin/keepalived /sbin/

步骤六:下载邮件服务,可以看到会有邮件告知哪台的down了

yum install mailx -y

步骤七:修改keepalived配置文件

vim /usr/local/keepalived/etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

notification_email {

root@localhost #节点宕机给谁发送邮件

}

notification_email_from keepalived@localhost ##发送人名称

smtp_server 127.0.0.1 #发送服务器(本机)

smtp_connect_timeout 30

router_id LVS_DEVEL

vrrp_skip_check_adv_addr

#vrrp_strict #注释掉,不然会有问题

vrrp_garp_interval 0

vrrp_gna_interval 0

}

vrrp_instance VI_1 {

state MASTER

interface eth0

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

172.25.1.100 #VIP

}

}

virtual_server 172.25.1.100 80 {

delay_loop 3 #当rs报错时,尝试多少次之后才邮件告知

lb_algo rr

lb_kind DR #DR模式

#persistence_timeout 50

protocol TCP

real_server 172.25.1.101 80 {

TCP_CHECK {

weight 1

connect_timeout 3

connect_port 80

}

}

real_server 172.25.1.102 80 {

TCP_CHECK {

weight 1

connect_timeout 3

connect_port 80

}

}

}

步骤八:开启keepalived服务

systemctl start keepalived

systemctl status keepalived

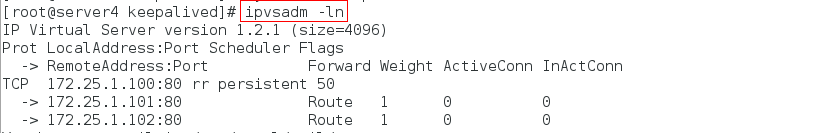

步骤九:安装ipvsadm服务,并开启

yum install ipvsadm.x86_64 -y

步骤十:开启ipvsadm服务

systemctl start ipvsadm.service

ipvsadm --save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

systemctl status ipvsadm.service

步骤十一:可以查看到eth0网卡上自动生成vip,及自动生成ipvsadm策略

ip addr show

ipvsadm -ln

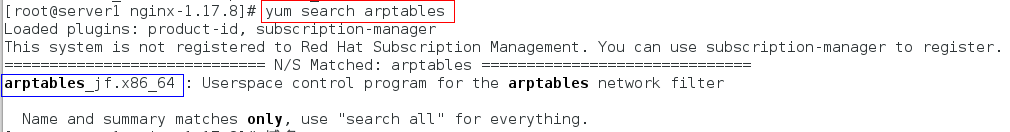

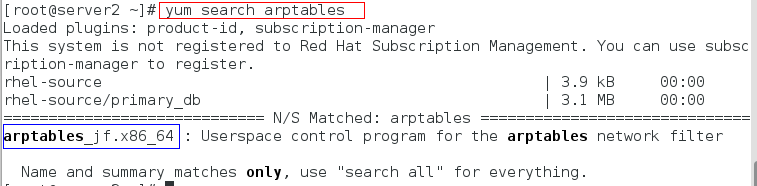

在nginx服务器(server1)上

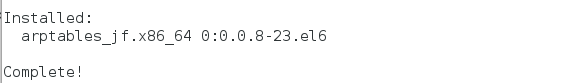

步骤一:查看arptables安装包,并安装

yum search arptables

yum install -y arptables_jf.x86_64

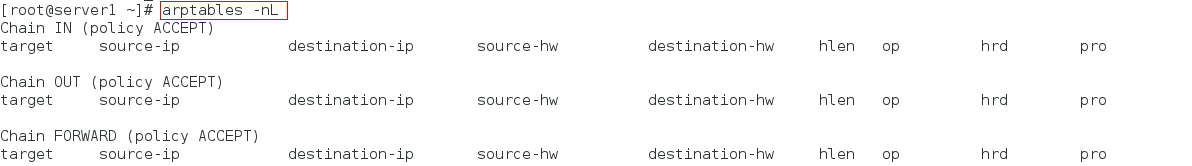

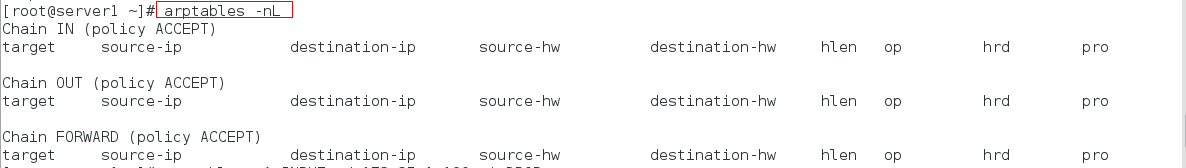

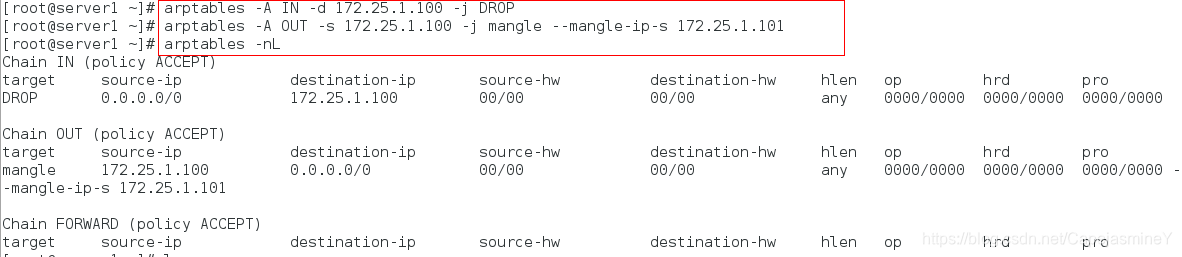

步骤二:查看设置的访问规则

arptables -nL

步骤三:设置规则

arptables -A IN -d 172.25.1.100 -j DROP

arptables -A OUT -s 172.25.1.100 -j mangle --mangle-ip-s 172.25.1.102

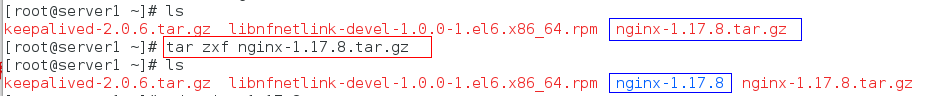

步骤四:下载nginx服务

(1)在官网上下载nginx安装包并解压

下载地址:nginx官网安装包下载地址

tar zxf nginx-1.17.8.tar.gz

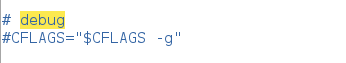

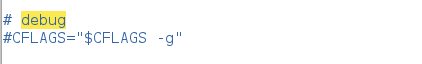

(2)修改源码编译gcc配置文件

cd nginx-1.17.8

vim auto/cc/gcc

# debug

#CFLAGS="$CFLAGS -g" ##本行注释掉,关闭debug日志模式

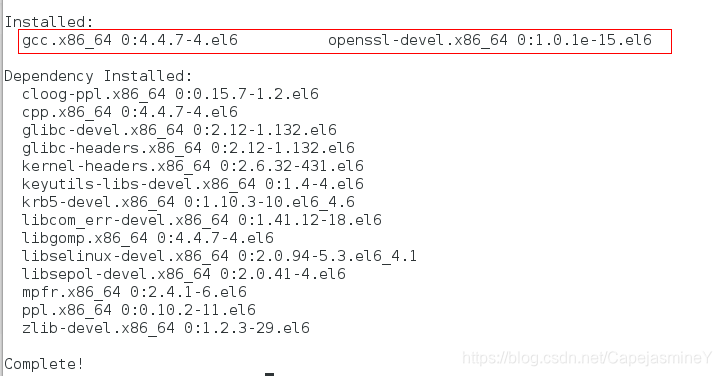

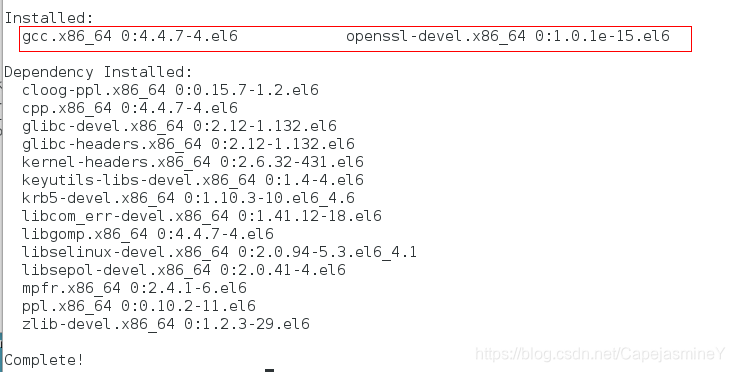

(3)安装编译环境

yum install gcc openssl-devel -y

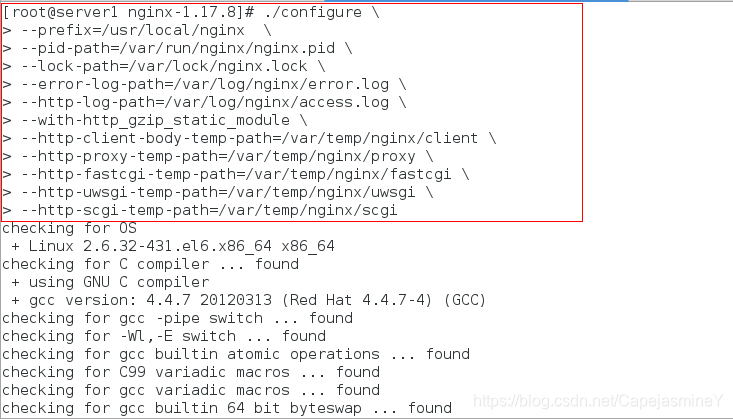

(4)编译

./configure

--prefix=/usr/local/nginx

--pid-path=/var/run/nginx/nginx.pid

--lock-path=/var/lock/nginx.lock

--error-log-path=/var/log/nginx/error.log

--http-log-path=/var/log/nginx/access.log

--with-http_gzip_static_module

--http-client-body-temp-path=/var/temp/nginx/client

--http-proxy-temp-path=/var/temp/nginx/proxy

--http-fastcgi-temp-path=/var/temp/nginx/fastcgi

--http-uwsgi-temp-path=/var/temp/nginx/uwsgi

--http-scgi-temp-path=/var/temp/nginx/scgi

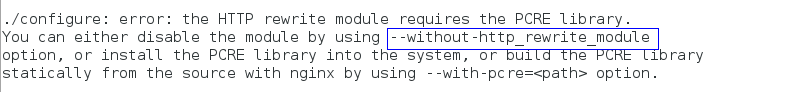

--without-http_rewrite_module

报错提醒:

报错提醒: 缺少模块,编译时填上:

缺少模块,编译时填上:

(5)编译安装

make && make install

(6)启动脚本做软链接

ln -s /usr/local/nginx/sbin/nginx /usr/local/sbin/

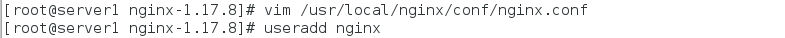

(7)修改配置文件,设置nginx为所有人所有组,并进行语法检测

vim /usr/local/nginx/conf/nginx.conf

user nginx nginx;

useradd nginx

nginx -t #检测语法

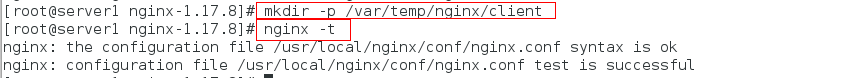

此时报错:

nginx: the configuration file /usr/local/nginx/conf/nginx.conf syntax is ok

nginx: [emerg] mkdir() “/var/temp/nginx/client” failed (2: No such file or directory)

nginx: configuration file /usr/local/nginx/conf/nginx.conf test failed

提示没有找到目录/var/temp/nginx/client

解决:

mkdir -p /var/temp/nginx/client

nginx -t

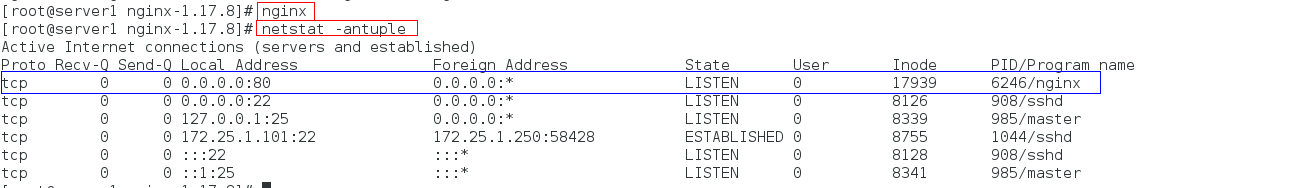

(8)开启nginx服务,查看进程

nginx

netstat -antuple | grep 80

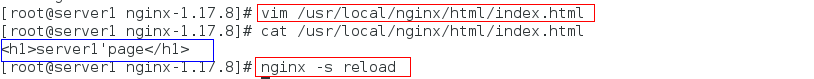

步骤五:编辑默认发布页面文件

vim /usr/local/nginx/html/index.html

<h1>server1's page </h1>

nginx -s reload

步骤六:在后端服务器上面设置用户访问的入口地址

ip addr add 172.25.1.100/32 dev eth0

ip addr show eth0

在nginx服务器(server2)上

步骤一:查看arptables安装包,并安装

yum search arptables

yum install -y arptables_jf.x86_64

步骤二:查看设置的访问规则

arptables -nL

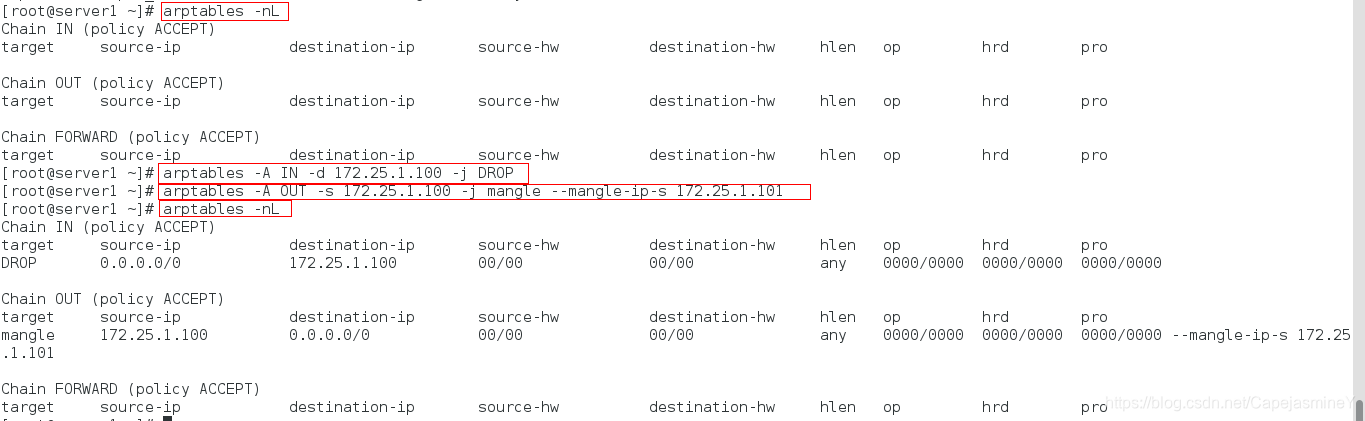

步骤三:设置规则

arptables -A IN -d 172.25.1.100 -j DROP

arptables -A OUT -s 172.25.1.100 -j mangle --mangle-ip-s 172.25.1.103

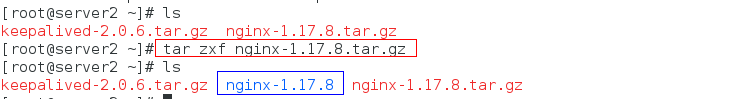

步骤四:下载nginx服务

(1)在官网上下载nginx安装包并解压

下载地址:nginx官网安装包下载地址

tar zxf nginx-1.17.8.tar.gz

(2)修改源码编译gcc配置文件

cd nginx-1.17.8

vim auto/cc/gcc

# debug

#CFLAGS="$CFLAGS -g" ##本行注释掉,关闭debug日志模式

(3)安装编译环境

yum install gcc openssl-devel -y

(4)编译

./configure

--prefix=/usr/local/nginx

--pid-path=/var/run/nginx/nginx.pid

--lock-path=/var

版权声明:本文来源CSDN,感谢博主原创文章,遵循 CC 4.0 by-sa 版权协议,转载请附上原文出处链接和本声明。

原文链接:https://blog.csdn.net/CapejasmineY/article/details/104415846

站方申明:本站部分内容来自社区用户分享,若涉及侵权,请联系站方删除。

-

发表于 2020-03-01 23:16:51

- 阅读 ( 1166 )

- 分类:架构

如果觉得我的文章对您有用,请随意打赏。你的支持将鼓励我继续创作!