社区微信群开通啦,扫一扫抢先加入社区官方微信群

社区微信群

社区微信群开通啦,扫一扫抢先加入社区官方微信群

社区微信群

线性回归是最简单的机器学习算法,说白了就是构造一元或者多元的线性方程,然后根据现有样本数据进行函数拟合,求解出线性方程的各个参数,之后就可以通过该线性方程进行相关预测。

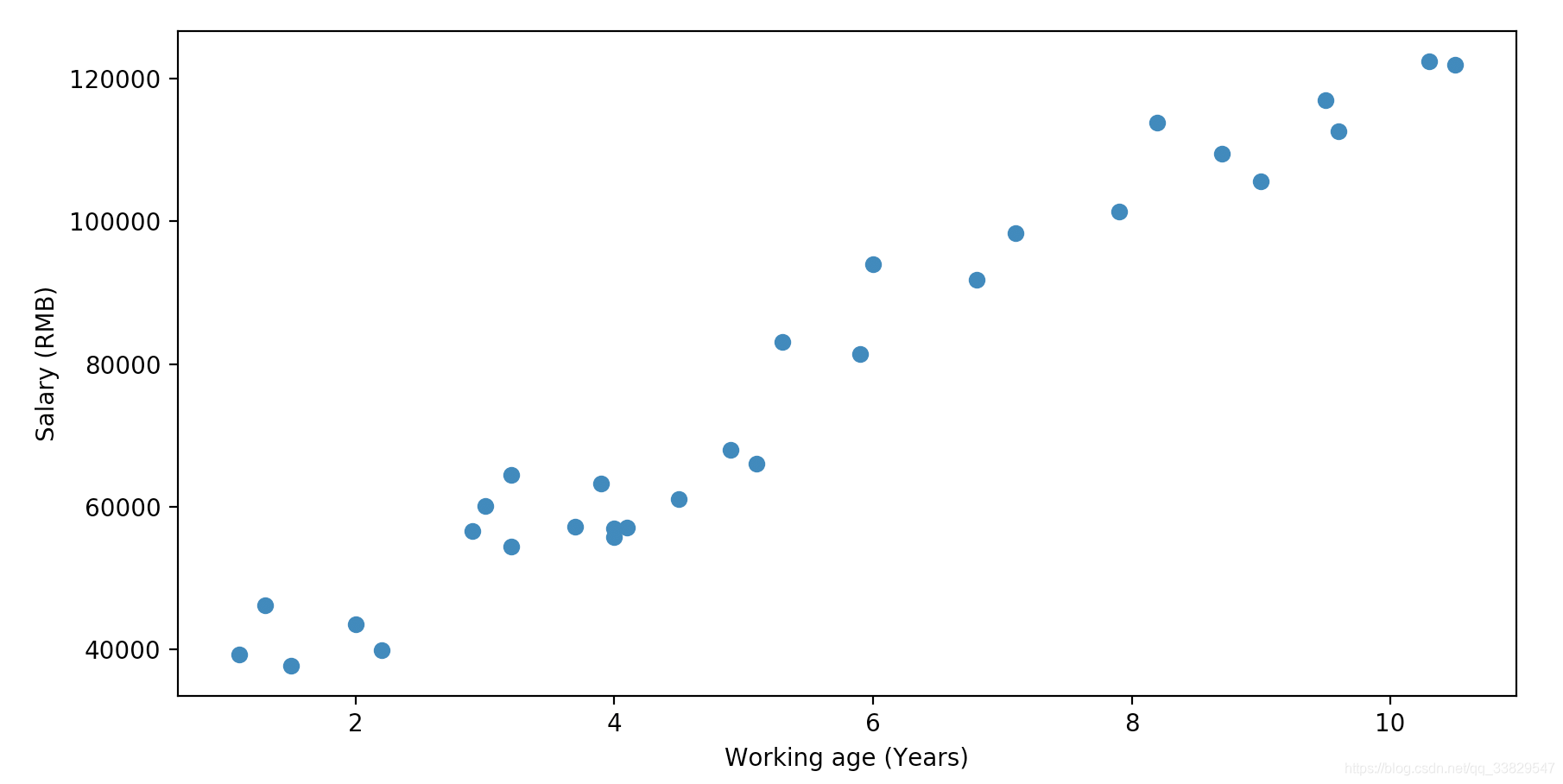

根据常识,一个人的工龄越长,那么这个人的工资也会随之增加。那么,我们现在想要知道,工龄对工资之间具体存在什么样的数学关系。

巧妇难为无米之炊,先放上一组数据:

| 工龄(年) | 工资(元) |

|---|---|

| 1.1 | 39343.00 |

| 1.3 | 46205.00 |

| 1.5 | 37731.00 |

| 2.0 | 43525.00 |

| 2.2 | 39891.00 |

| 2.9 | 56642.00 |

| 3.0 | 60150.00 |

| 3.2 | 54445.00 |

| 3.2 | 64445.00 |

| 3.7 | 57189.00 |

| 3.9 | 63218.00 |

| 4.0 | 55794.00 |

| 4.0 | 56957.00 |

| 4.1 | 57081.00 |

| 4.5 | 61111.00 |

| 4.9 | 67938.00 |

| 5.1 | 66029.00 |

| 5.3 | 83088.00 |

| 5.9 | 81363.00 |

| 6.0 | 93940.00 |

| 6.8 | 91738.00 |

| 7.1 | 98273.00 |

| 7.9 | 101302.00 |

| 8.2 | 113812.00 |

| 8.7 | 109431.00 |

| 9.0 | 105582.00 |

| 9.5 | 116969.00 |

| 9.6 | 112635.00 |

| 10.3 | 122391.00 |

| 10.5 | 121872.00 |

根据这些样本数据,可以得出下面的散点图:

这里我们可以根据散点图的大致走向进行猜测,工龄x与工资y之间是一元线性关系,于是我们可以写出如下线性方程:

h(x)=θ0+xθ1

其中:

上述是线性方程最简单的形式,更普遍的情况下可能会有n个特征值,即以下这种形式:

h(x)=θ0+x1θ1+x2θ2+...+xnθn=x0x0=1θ0+x1θ1+x2θ2+...+xnθn=i=0∑n(xiθi)

由于机器学习中基本使用矩阵进行运算,为了后续数学推导,因此我们将上述式子改写为矩阵的形式:

h(x)=i=0∑n(θixi)=⎣⎢⎢⎡x0x1...xn⎦⎥⎥⎤×[θ0θ1...θn]=XΘ

其中:

接下来,我们要考虑到实际值与线性方程的解肯定会存在误差,这里我们用ϵ来表示误差项:

y真实值=(XΘ)预测值+ϵ误差项(1)

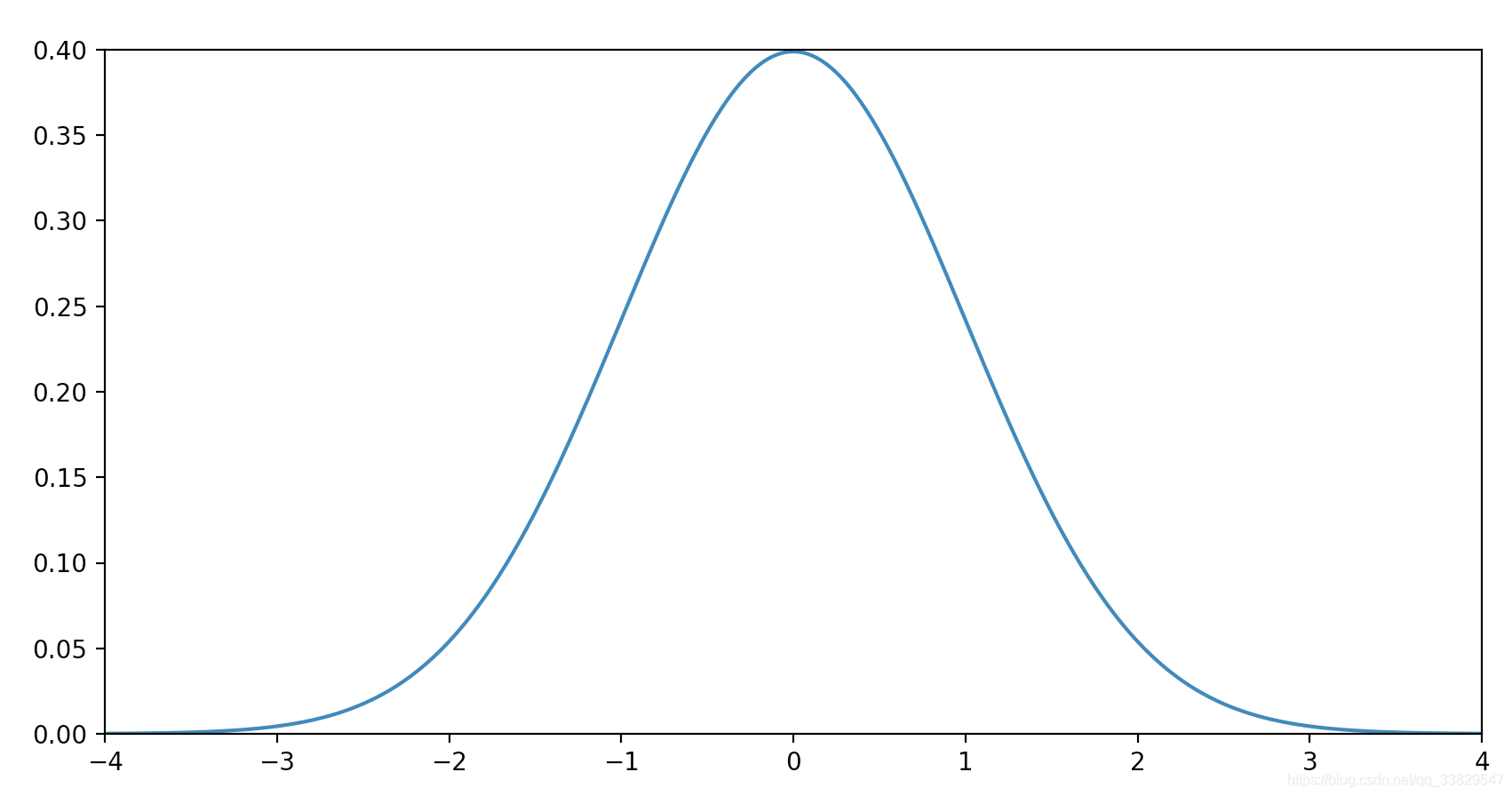

我们当然希望误差项ϵ越小越好,这里我们假定误差项ϵ是独立的并且服从均值为0、方差为θ2的高斯分布:

我们可以直接写出每一个样本的误差项ϵ的概率函数

p(ϵ(i))=2πσ1exp(−2σ2(ϵ(i))2)(2)

结合(1)(2)可得:

p(ϵ(i))=2πσ

版权声明:本文来源CSDN,感谢博主原创文章,遵循 CC 4.0 by-sa 版权协议,转载请附上原文出处链接和本声明。

原文链接:https://blog.csdn.net/qq_33829547/article/details/97910807

站方申明:本站部分内容来自社区用户分享,若涉及侵权,请联系站方删除。

如果觉得我的文章对您有用,请随意打赏。你的支持将鼓励我继续创作!