社区微信群开通啦,扫一扫抢先加入社区官方微信群

社区微信群

社区微信群开通啦,扫一扫抢先加入社区官方微信群

社区微信群

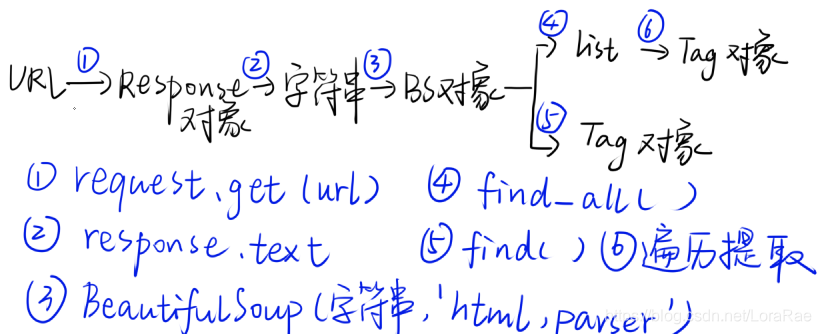

上一篇文章写了如何用BeautifulSoup解析数据,接下来这篇文章将写如何用BeautifulSoup提取数据。

find()与find_all()

find()与find_all()是BeautifulSoup对象的两个方法。

它们可以匹配html的标签和属性,提取BeautifulSoup对象里符合要求的数据。

两个用法基本是一样的。

区别在于,find()只提取首个满足要求的数据,而find_all()提取出的是所有满足要求的数据。

用法看下面代码:

import requests

from bs4 import BeautifulSoup

url = '随便复制一个网站'

res = requests.get (url)

print(res.status_code)

soup = BeautifulSoup(res.text,'html.parser')

item = soup.find('div') #使用find()方法提取首个<div>元素,并放到变量item里。

print(type(item)) #打印item的数据类型

print(item) #打印item import requests

from bs4 import BeautifulSoup

url = '随便一个网站'

res = requests.get (url)

print(res.status_code)

soup = BeautifulSoup(res.text,'html.parser')

items = soup.find_all('div') #用find_all()把所有符合要求的数据提取出来,并放在变量items里

print(type(items)) #打印items的数据类型

print(items) #打印itemsTag对象

Tag对象是一种数据类型,有三种用法:

1.Tag对象可以使用find()与find_all()来继续检索。

2.用Tag.text提出Tag对象中的文字。

3.用Tag[‘href’]提取出URL。(Tag[‘属性名’])

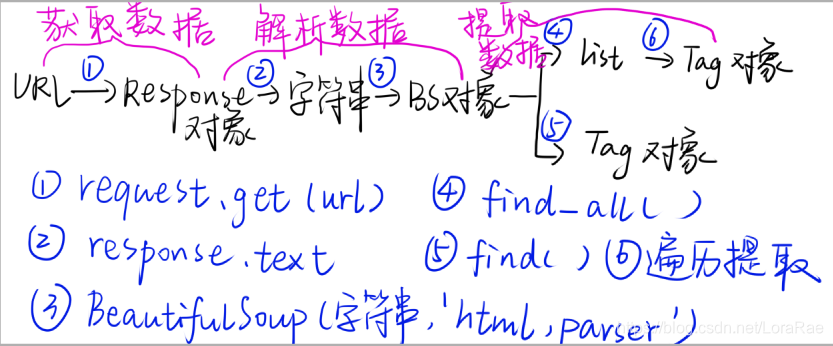

到目前为止,爬虫的四部已经完成了三部。

爬虫四步:

1.获取数据。2.解析数据。3.提取数据。4.储存数据。

如果觉得我的文章对您有用,请随意打赏。你的支持将鼓励我继续创作!