离线数据分析平台是一种利用hadoop集群开发工具的一种方式,主要作用是帮助公司对网站的应用有一个比较好的了解。尤其是在电商、旅游、银行、证券、游戏等领域有非常广泛,因为这些领域对数据和用户的特性把握要求比较高,所以对于离线数据的分析就有比较高的要求了。

讲师本人之前在游戏、旅游等公司专门从事离线数据分析平台的搭建和开发等,积累了一些这方面比较实用的技能点,特意整理录制成视频,本项目全程手敲,适合各层次学员学习本视频的知识点。当然对于对hadoop有一定了解的学员而言,大家一看就知道是对hadoop生态圈的基本应用,但是同时在视频中也涉及到一些hadoop源码相关的知识点。预祝每位学员能够成为hadoop开发的行家里手。

1.课程研发环境

开发源代码以JDK7作为基准,数据库采用mysql,使用hadoop生态圈相关软件应用于该项目。

开发工具: Eclipse;

数据库工具: Mysql

其他工具: Hadoop、Hbase、Hive、Sqoop、Flume、Oozie、Nginx、Highcharts、SpringMVC等

2.内容简介

本教程从hadoop基本环境的搭建开始、介绍项目相关信息以及展示highcharts展示技术等。此外,为了帮助学员更好的理解知识点,介绍了hadoop、hbase、hive等hadoop生态圈的安装配置和使用等。项目主要涉及到用户行为数据的收集、用户数据的etl操作、用户数据的分析以及分析数据展示等项目模块,最终展示了一个基本的离线数据分析平台的全部实现。

一、大数据基本技能储备:

第一讲:项目介绍以及Hadoop环境搭建

第二讲:Hadoop Shell命令介绍--上

第三讲:Hadoop Shell命令介绍--下

第四讲:HDFS介绍以及Java API介绍

第五讲:MapReduce结构以及编程模型介绍

第六讲:MapReduce进阶上

第七讲:MapReduce进阶下

第八讲:Hbase介绍以及Hbase环境搭建

第九讲:Hbase客户端介绍

第十讲:Hbase和Mapreduce整合

第十一讲:Hive介绍和Hive环境搭建

第十二讲:Hive Shell命令介绍上

第十三讲:Hive Shell命令介绍下

第十四讲:Hive函数以及自定义函数讲解

第十五讲:Flume介绍

第十六讲:Sqoop介绍

第十七讲:Oozie介绍以及环境搭建

第十八讲:Oozie工作流使用介绍

第十九讲:Highcharts介绍

第二十讲:Spring+MyBatis+Mysql框架整合

二、项目需求介绍

第二十一讲:需求分析一

第二十二讲:需求分析二

第二十三讲:需求分析三

三、用户行为数据收集模块实现讲解

第二十四讲:JavaSDK数据收集引擎编写

第二十五讲:JSSDK数据收集引擎编写

四、数据分析模块实现讲解

第二十六讲:用户数据etl操作一

第二十七讲:用户数据etl操作二

第二十八讲:新增用户和总用户分析

第二十九讲:活跃用户分析

第三十讲:活跃会员分析

第三十一讲:新增会员和总会员分析

第三十二讲:会话分析

第三十三讲:Hourly分析

第三十四讲:浏览器PV分析

第三十五讲:公用代码提取

第三十六讲:地域信息分析

第三十七讲:外链信息分析

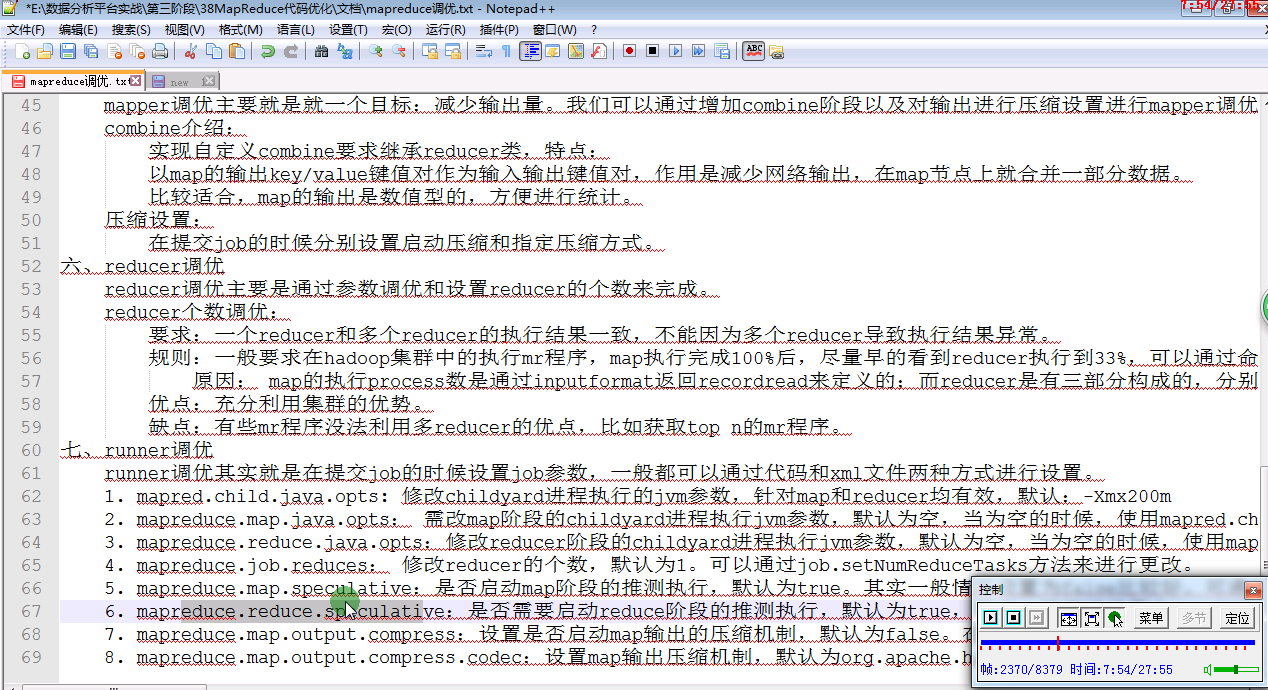

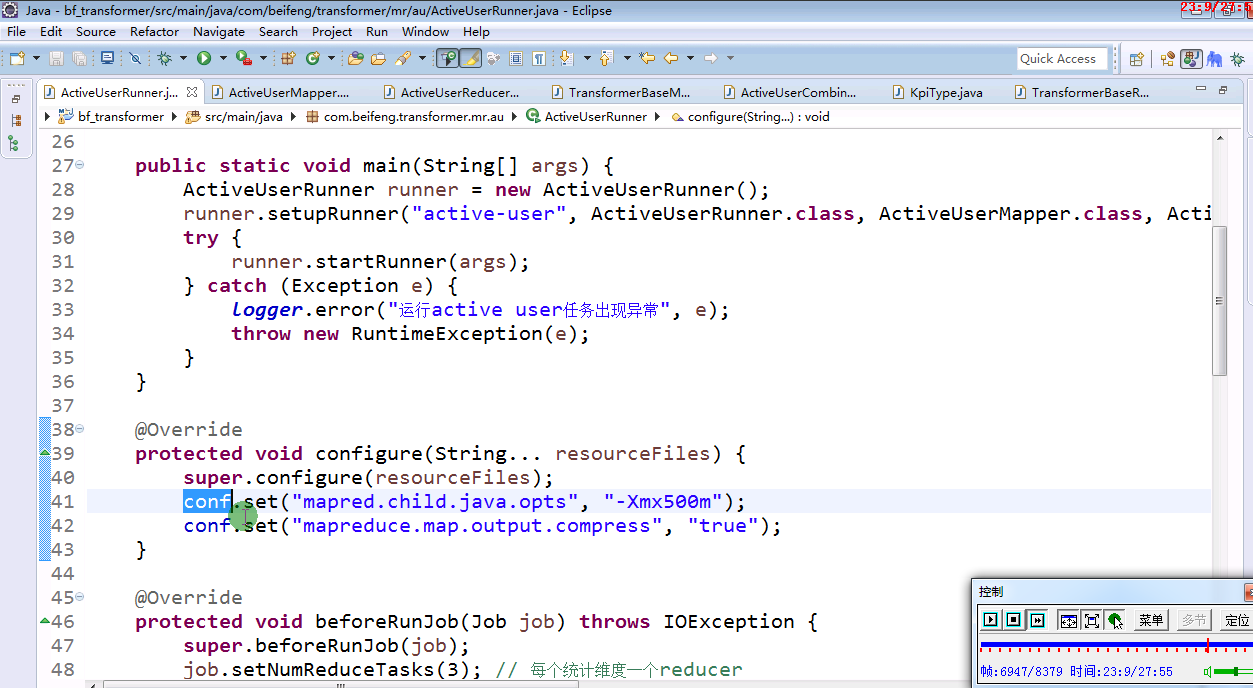

第三十八讲:MapReducer代码优化

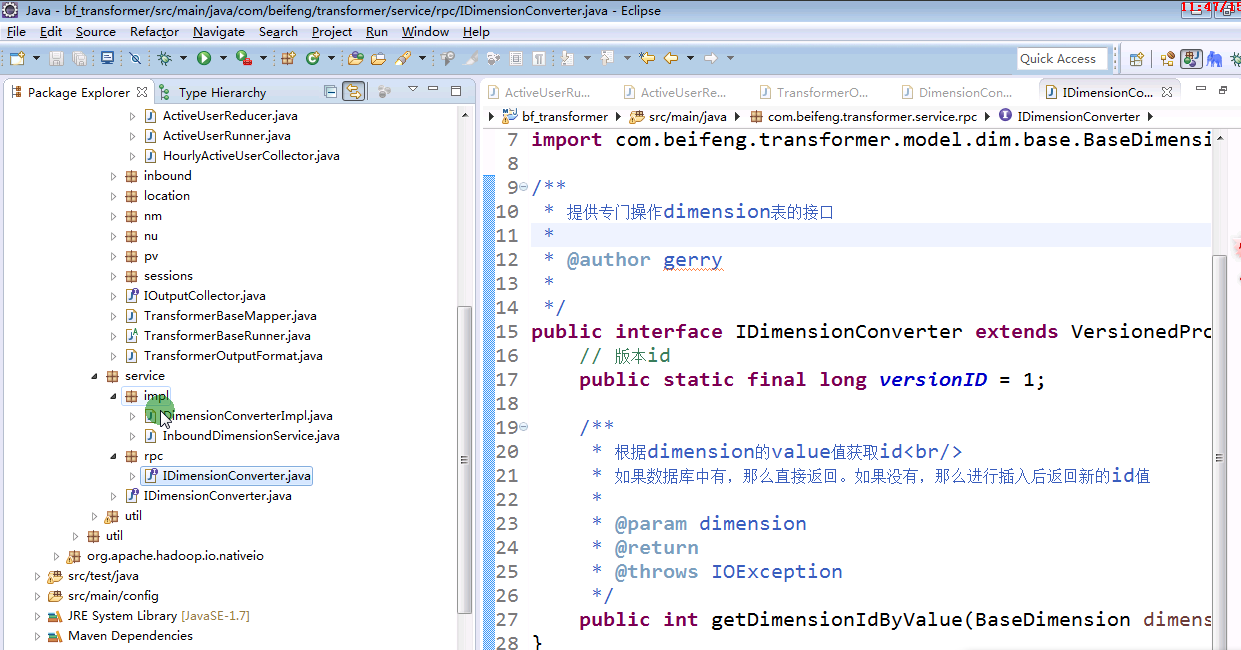

第三十九讲:DimensionConverter相关服务设计

第四十讲:用户浏览深度分析

第四十一讲:事件分析

第四十二讲:订单分析

第四十三讲:MR和Hive任务Oozie部署

五、数据展示模块讲解:

第四十四讲:DataApi后台框架搭建

第四十五讲:用户基本信息数据展示

第四十六讲:浏览器基本信息数据展示

第四十七讲:地域信息数据展示

第四十八讲:用户浏览深度数据展示

第四十九讲:外链数据展示

第五十讲:事件数据展示

第五十一讲:订单数据展示以及项目总结

目标一. 了解hadoop的环境配置以及hadoop的基本运用管理

目标二. 了解hbase的环境配置以及hbase的基本运用管理

目标三. 了解hive的环境配置以及hive的基本运用管理

目标四. 了解flume、sqoop、oozie等hbase生态环境的配置以及基本应用管理

目标五. 了解SpringMVC、MyBatis以及Highcharts的整合使用

目标六. 了解Flume+Nginx+JS的用户行为数据收集

目标七. 通过前后台的分离,让学生掌握highcharts动态展示数据的基本使用

目标八. 通过数据分析任务的编写,让学生掌握mr和hive的编写

目标九. 通过完整项目实战,全面演示hadoop生态圈的搭建、开发、注意事项以及技巧

目标十. 通过本次课程的学习,为学员以后再工作中如何使用hadoop有一个初步的了解,对应hadoop和传统项目的整合有一个整体的了解,奠定基础

亮点一、理论与实战相结合,由浅入深。即照顾到基础学员,也照顾到一定经验的学员,在讲解过程中也为学员留下了大量的考虑时间。

亮点二、课程所有代码基本上是一行一行手工敲入,特别是对应使用hadoop和hive开发的部分代码,手把手一步步带学员从入门到精通。

亮点三、整个项目涉及到一个工作流程的全部,包括用户行为数据的收集、数据分析以及分析结果展示等各个方面。而且讲师框架全部按照大的项目框架去搭建,学员拿到该项目后,稍加修改就可以应用到自己的项目中去,实用性超强。

亮点四、对应hadoop生态圈讲解的比较细,对应如何应用hadoop生态圈有一个初步的讲解。学员通过学习该视频后,基本对如何在工作中使用hadoop有一个初步的了解。

1.课程针对人群

本课程针对具有一定的java、linux、maven基础以及对hadoop生态环境有一个初步了解的学员,想通过本项目的学习,加深对hadoop生态圈的了解、hadoop和传统开发整合开发商业项目的学员。也适合想深入了解hadoop项目应用的学员。

2.我该怎么学,如何才能学好这门课程,给些建议。

2.1、时间上的安排建议

本课程共113课时,分为51讲。如果您时间上充分,建议以每天1-2讲的进度往前学习。

2.2、学习要求

如果您没有基础,建议还是中规中矩的按照课程进度一点一点仔细观看学习,并一定要把看完的视频中的代码自己手敲一遍,以加深理解和记忆

如果您有基础,可不必按步就搬进行,可以拿你感兴趣的部分去学习,但一定要注意实践,并学会举一反三

如果您只是想了解hadoop的应用,可以直接看后面的几部分的视频

2.3、讲师建议

1.最好看完视频之后,抛开视频,独立自己去把上课中的示例写一遍,看自己是否理解,如果不正确,可以回过头看再看下视频,如果反复,达到真正理解和熟练掌握的目的。

2.对于项目实战部分,一定要自己亲自动手做一遍,不要满足听完就OK了

3. 建议一般听视频,一般拿个纸和笔,做一些记录和笔记,这是一种非常好的学习习惯。

4. 一定不要过于依赖视频,要学会看API和使用官网实例以及使用搜索引擎,学会思考,学会举一反三

5. 最后祝您学有所成

课程是属于某个特定的专业技术,掌握该技术后,你可以从事以下职位的相关工作

1. Hadoop开发工程师

2. Hive开发工程师

3. Java开发工程师(代码展示部分涉及到数据展示的java代码开发)